在今年7月份ISC(Internatinal Supercomputing Conference,国际超级计算大会)公布的世界五百强超级计算机排名中有几个现象,一是InfiniBand第一次在总体份额上面超过以太网,成为最主流的在高性能计算机中应用的一种网络。二是使用Mellanox 100G每秒的EDR InfiniBand的超级计算机开始出现在排名里面,分别处于美国、欧洲和中国。

Mellanox在推动HPC(高性能计算)高速互联网络有其独到之处,几年前,Mellanox就开始推“联合设计(Co-Design)”理念,如今,联合设计的理念更为清晰。近日,Mellanox市场副总裁Gilad Shainer在接受ZD至顶网采访时阐述了联合设计的最新进展以及产品技术支撑。

Mellanox市场副总裁Gilad Shainer

为什么需要联合设计?

CPU是计算机的运算核心,英特尔推崇的概念是把CPU和网络集中起来,希望把所有的计算和通讯单元都集中到一个组件里面。Mellanox推动的联合设计截然相反,它是让所有的计算机里面单元都成为一个协同处理器。

Gilad Shainer对此说,“过去的系统组成部分都是单个体去发展性能,例如CPU厂商是集中精力做CPU、网络厂商集中精力做网络,还包括存储厂商等都在各自为政发展自己的组成部分的性能。但很难组装起来后让整个系统的性能不断提升,只有充分发挥系统的效率和性能,应用程序的效率和性能才能提高。”

Mellanox倡导的联合设计(Co-Design)结构

为了达成系统级别的性能提升,在Mellanox看来,需要这些不同的系统组成部分联合起来做联合设计的架构。第一层面是软件和硬件之间,为了充分发挥硬件的特性,软件必须要去适应它做一些改动。第二层面是硬件到硬件,例如GPU-Direct,这是网络厂商和GPU厂商之间做的一个工作,让GPU能够直接访问网卡,网卡能够直接去发送FDR GPU的内容,这里面都没有CPU的介入,那就是硬件与硬件之间走了更短的路径。第三层面是软件到软件,Mellanox成立了OPEN UCX,这里面的软件公司把自己最优秀的程序贡献出来,同时去互相交流,创建一个适合HPC更好性能更高的软件组合。最后一个层面就是从工业界到用户到学术界三方的合作,让工业界开发的东西能够更快的收到用户的反馈,同时加入学术界的一些创新进来。

Gilad Shainer举例到,十年前,网络延迟大概在10个微秒,这是在硬件层面。整个系统应用,除了硬件的延迟还有软件的延迟,这时软件的延迟大概是一百微秒,软件和硬件的差距是十倍。而今天硬件延迟下降了一百倍,软件延迟只下降了十倍。“硬件再怎么去优化,基本上达到物理极限,由于软件负荷的比例太大,所以导致整个应用程序的性能提升微乎其微。”

这也是进行联合设计的必要性,让软件的延迟能够下降得更快,而不是只盯着硬件,Gilad Shainer透露,在今年年底或明年年初,Mellanox将会有一个新的产品,来证明联合设计会带来多大的实际好处。

联合设计助力高性能计算

联合设计让原来集中式的、所有功能都放在以CPU为核心的处理器上的这种工作方式,演变为让各个单元组件分担工作负担的一种工作方式。“在将来的这种工作方式里面,网卡也将像CPU这种组件一样,变成一个核心的组件。”

Gilad Shainer表示,通过软件定义的方式,让更多的硬件组成部分承担更多的任务,这些组件里面,包括网卡、交换机、存储,甚至是网线等。有了软件定义的概念,我们以前没有想到的硬件组成部分,都有了自己的“大脑”,它会变成一个智能的组成部分,去分担应用程序的一部分任务,而不再是以CPU为一个核心单元。通过硬件卸载的方式,让很多组件协同完成一个任务,整个系统的性能才会达到一个更好的层次。

联合设计还会推动虚拟化这个在高性能计算领域不太搭配的技术应用,甚至虚拟化和高性能计算过去一直是互相排斥的概念,因为HPC一应用起来就是百分之百的CPU占用率,不使用虚拟化是因为它会带来性能牺牲。通过很多技术协同和卸载的功能,可以让虚拟化做到更高效率、极少的性能牺牲,从而可以利用虚拟化技术带给HPC的好处。

Mellanox网络不增加投资 性能提升可观

Gilad Shainer指出,联合设计加入进来的组织越来越多,已经取得了不错的成绩,特别是软硬件的协同开发,通过运行的一些应用程序的测试,可以看到非常好的性能提升的结果,“这些应用程序使用了EDR能够升高40%的性能,覆盖的领域包括了分子动力学、流体力学、天气预报等。”

Gilad Shainer强调,“在联合设计的理念情况下,再使用我们100G的InfiniBand网络,应用程序性能提升更明显,节点数越多,差距会越大,可能在50个节点就有50%的差距了。”

并且,在投入上面,“Mellanox的网络占比在整个系统投资占比里面是很少的。再从FDR升级到EDR,我们可能增加的投资不多,但是系统性能却增加了40%,这是一个非常直观的对比。”

据介绍,现在最高性能的Mellanox产品是100G每秒的InfiniBand产品。而且在运行到100G吞吐量的时候,完全不占用CPU,这也是联合设计的一个概念。现在,Mellanox的发展方向已经迈向了200G。

Mellanox同样不输以太网

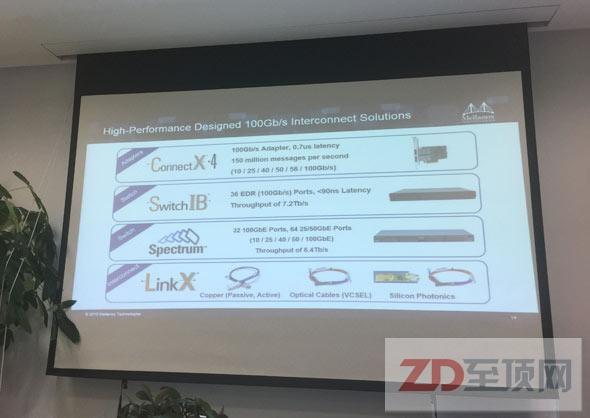

Mellanox的优势不仅仅体现在InfiniBand网络,在以太网领域也拥有不可忽视的地位。Mellanox今年6月份在美国纽约正式推出25Gbps、50Gbps和100Gbps芯片(Connect X4 ROX)及Spectrum交换机,Gilad Shainer强调Spectrum是不丢包的交换机。

Gilad Shainer同时指出Spectrum的另一个标签,属于开放以太网的交换机,“用户可以选择使用我们的交换机,但是软件上面可以使用第三方的网络管理软件,包括一些开源的网络管理软件等。我们是不把用户锁死在一个网络提供商上面,软件有你自由选择的灵活度。”

在网卡方面,Mellanox重点集中在25G和50G以太网,在Mellanox看来,25G就是新的万兆,50G是新的4万兆以太网。所以它们是替换这两个网络的产品方向,对用户来说,这种替代带来的性能提升是明显的,但成本和连接方式却相差无几。

据介绍,Mellanox即将在北京召开一场别开生面的发布会,关于联合设计和Mellanox 100Gb以太网产品线Spectrum及端到端25Gb和50Gb产品家族即将在中国重装亮相。