该公司证实,Nvidia 的大语言机型将于今年晚些时候全面上市。

企业广泛依赖 Nvidia 的图形处理器来编写人工智能应用程序。该公司还创建了与 OpenAI 的 GPT-4 和谷歌的 PaLM-2 类似的专有预训练模型。

客户可以使用自己的数据语料库,将其嵌入到 Nvidia 预先训练好的大型语言模型中,然后构建自己的人工智能应用。基础模型涵盖文本、语音、图像和其他形式的数据。

Nvidia 有三个基础模型。其中最广为人知的是 NeMo,它包括 Megatron,客户可以在其中构建 ChatGPT 风格的聊天机器人。NeMo 还具有 TTS 功能,可将文本转换为人类语音。

第二个模型是 BioNemo,这是一个针对生物技术行业的大语言模型。Nvidia 的第三个人工智能模型是 Picasso,它可以处理图像和视频。客户可以通过 Nvidia 及其合作伙伴提供的软件和服务产品使用 Nvidia 的基础模型。

"Nvidia 产品营销总监 Dave Salvator 在电话会议上说:"我们将在今年晚些时候提供基础模型服务。Nvidia 的女发言人没有具体说明特定机型的上市日期。

NeMo 和 BioNeMo 服务目前正通过 AI Enterprise 软件向客户提供早期服务,很可能成为首批商用服务。Picasso 离发布时间还很远,围绕该机型的服务可能不会那么快推出。

"Nvidia 发言人说:"我们目前正在与部分客户合作,其他感兴趣的客户可以注册,以便在服务更广泛地开放时获得通知。

这些机型在 Nvidia GPU 上运行效果最佳,而 Nvidia GPU 供不应求。Nvidia 首席财务官科莱特-克雷斯(Colette Kress)在本周举行的花旗全球技术大会上表示,公司正在努力满足需求。

GPU 短缺给采用带来了障碍,但客户可以通过 Nvidia 的 DGX 云或亚马逊网络服务、谷歌云、微软 Azure 或甲骨文云访问 Nvidia 的软件和服务,它们都安装了 H100。

Nvidia 的基础模型是该公司 "人工智能工厂 "概念的重要组成部分,客户无需担心编码或硬件问题。人工智能工厂可以接收原始数据,并通过 GPU 和 LLM 进行处理。其输出结果就是为公司提供可操作的数据。

LLM 将是 AI Enterprise 软件套件的一部分,其中包括框架、基础模型和其他 AI 技术。技术堆栈还包括无代码人工智能编程环境 Tao 和 NeMo Guardrails 等工具,后者可以分析和重定向输出,以提供更可靠的响应。

Nvidia 依靠合作伙伴销售并帮助企业在其加速计算平台上部署 NeMo 等人工智能模型。

Nvidia的一些合作伙伴包括软件公司Snowflake和VMware以及人工智能服务提供商Huggingface。Nvidia 还与咨询公司德勤(Deloitte)合作,进行更大规模的部署。Nvidia已经宣布,它将把NeMo LLM带到Snowflake数据云上,顶级企业的数据都存放在Snowflake数据云上。Snowflake Data Cloud 用户将能够通过将其数据与 NeMo 和 Nvidia 的 GPU 连接,生成与 AI 相关的见解并创建 AI 应用程序。

与 VMware 的合作为 VMware 私有云带来了 AI Enterprise 软件。VMware的vSphere和Cloud Foundation平台为在云中跨Nvidia硬件的虚拟机中部署人工智能提供了管理工具。这些部署还可以扩展到非 Nvidia CPU。

Nvidia 公司负责企业计算的副总裁 Manuvir Das 在高盛的 Communacopia+Technology 会议上说,Nvidia 大约 80% 是一家软件公司,其软件平台是人工智能的操作系统。

达斯说:"去年,人们还在想人工智能能带来什么帮助,但今年,"客户现在来找我们,因为他们已经知道用例是什么了。人工智能的准入门槛仍然很高,挑战在于开发 NeMo、GPT-4 或 Meta 的 Llama 2 等基础模型。

"你必须找到所有的数据、正确的数据,并对其进行整理。在获得可用模型之前,你必须经历整个训练过程,"达斯说。

不过,经过数百万美元的开发和培训投资后,这些模型现在已经可以提供给客户了。

"现在,它们已经可以使用了。你可以从这里开始,用自己的数据进行微调,然后使用模型,"达斯说。

Nvidia 预计,人工智能企业软件栈的市场机会为 1500 亿美元,是包括 GPU 和系统在内的 3000 亿美元硬件机会的一半。该公司首席执行官黄仁勋(Jensen Huang)此前曾谈到,人工智能计算将彻底改变过去依赖CPU的计算方式。

开源 Tensor-RT LLM

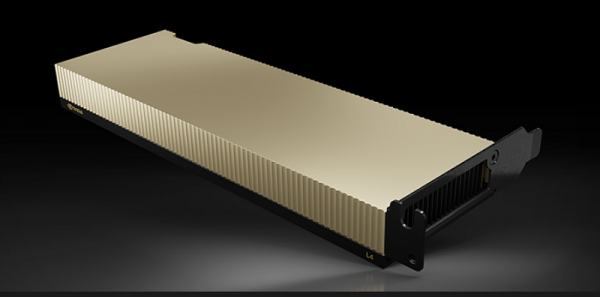

Nvidia-L4-GPU-600x297

Nvidia 单独发布了 Tensor-RT LLM,它可以提高基础模型在其 GPU 上的推理性能。该运行时可以提取各种模型的最佳推理性能,如 Bloom、Falcon 和 Meta 最新的 Llama 模型。

重型 H100 被认为是训练模型的最佳选择,但考虑到 GPU 的功耗和性能,对于推理来说可能会显得力不从心。Nvidia 有用于推理的低功耗 L40 和 L4 GPU,但如果 GPU 不忙,H100 也可用于推理。

Nvidia 超大规模和高性能计算副总裁 Ian Buck 表示,Tensor-RT LLM 专门针对 H100 上的低级推理进行了优化,以减少空闲时间,使 GPU 占用率接近 100%。

Buck说,与A100 GPU相比,Hopper和Tensor-RT LLM软件的组合将推理性能提高了8倍。

"随着人们开发新的大型语言模型,这些内核可以重复使用,继续优化和提高性能,并建立新的模型。随着社区实施新技术,我们将继续把它们......放到这个开源资源库中,"Buck 继续说。

张量 RT-LLM 为 GPU 提供了一种新的调度程序,称为机内批处理。该调度器允许工作独立于其他任务进入和退出 GPU。

"过去,批处理是以工作请求的形式出现的。批处理被调度到 GPU 或处理器上,当整个批处理完成后......下一个批处理就会进入。不幸的是,在高可变性工作负载中,这将是最长的工作负载......我们经常看到 GPU 和其他东西利用率不足,"Buck 说。

有了 Tensor-RT LLM 和飞行中批处理,工作可以独立、异步地进入和离开批处理,使 GPU 保持 100% 的占用率。

"Buck 说:"这一切都会在 Tensor RT-LLM 运行时系统内自动发生,从而显著提高 H100 的效率。

该运行时目前处于早期访问阶段,很可能在下个月发布。